Numérique : L’important projet ARTEMIS du ministère des Armées est-il trop ambitieux pour réussir?

Afin de profiter des applications permises par le traitement massif des données [Big Data] et l’intelligence artificielle [IA], la Direction générale de l’armement a lancé, en 2017, le programme ARTEMIS IA [ARchitecture de Traitement et d’Exploitation Massive de l’Information multi-Sources], avec l’objectif de doter le ministère des Armées d’une solution « souveraine » en matière de stockage et d’exploitation de l’information.

Aussi, si un tel programme n’a pas la même visibilité que celle dont bénéficient d’autres projets d’armement [SCORPION, porte-avions de nouvelle génération, Rafale, etc], il n’est reste pas moins qu’il a une importance capitale. « Le traitement massif des données, c’est le nouveau nerf de la guerre. C’est ce qui nous permettra de prendre la bonne décision » et par conséquent, « nous ne pouvons donc dépendre de personne », avait ainsi résumé Florence Parly, la ministre des Armées, lors d’un déplacement à la base aérienne de Creil.

Après une première phase compétitive devant conduire à la présentation de « démonstrateurs », ARTEMIS a été confié par la DGA à Athea, une co-entreprise formée par Thales et Atos, avec Cap Gemini et Sopra-Steria comme sous-traitants. Mais au-delà de ces entreprises, le programme s’appuie sur tout un éco-système constitué de PME, de start-ups et de laboratoires spécialisés dans le traitement des données et l’intelligence artificielle.

Jusqu’à présent, ce programme a coûté 56 millions d’euros pour les phases 1 et 2. Quant au budget de la phase 3, il reste à déterminer. Toutefois, le montant de 300 millions d’euros est avancé.

Pour le moment, le projet en est à la seconde phase, laquelle a démarré en 2019, avec l’objectid de « démontrer les performances de la plateforme ARTEMIS à travers plusieurs démonstrateurs ainsi que son aptitude à intégrer des cas d’usage métier variés et représentatifs des besoins des ADS », rappelle le député Fabien Gouttefarde, rapporteur pour avis sur les crédits du programme « Environnement et prospective de la politique de défense » [.pdf].

« Une version intermédiaire des démonstrateurs d’ARTEMIS est aujourd’hui testée sur plusieurs déploiements pilotes au sein du ministère des Armées. Le projet ARTEMIS fait l’objet en 2021 de travaux d’optimisation et de préparation de son industrialisation », poursuit le parlementaire, qui précise que le démarrage de la phase de réalisation du projet est attendue en 2022.

Au total, ARTEMIS prévoit six « cas d’usage ». Le premier, intitulé « aide à l’exploitation des données massives, hétérogènes » doit déboucher sur un « outil d’exploitation permettant le croisement de données structurées et non structurées », offrant ainsi la possibilité d’effectuer des « analyses multidimensionnelles sur la base de critères géographiques, temporels, relationnels ou statistiques ». Le second concerne la cybersécurité, l’enjeu étant de pouvoir détecter les anomalies dans de « grands volumes d’évènements journalisés ». Quant au troisième, il portera sur le « suivi de la santé des militaires », l’idée étant d’améliorer la prévention et la prise en charge.

Un autre cas d’usage, appelé « intelligence technique et économique », promet de faciliter la recherche d’informations dans une masse de documents et d’en faire la synthèse. Il est aussi question de développer un « outil d’élaboration de la situation maritime, tirant parti du croisement de différentes sources de données », pour identifier des « modèles de comportement y compris anormaux et dans la prédiction de la situation maritime future ». Enfin, le dernier cas concernera la maintien en condition opérartionnelle [MCO], avec la mise au point d’un système d’analyse prévisionnelle et de gestion des flottes [aéronefs et véhicules, ndlr].

Aussi, ARTEMIS est un projet compliqué, soumis par ailleurs à des impératifs de sécurité évidents. Il doit « prendre en compte les nombreuses spécificités du monde de la Défense que sont la protection des données, la multiplicité des réseaux et des niveaux de classification, la gestion du besoin d’en connaître, l’accès aux algorithmes et aux données, tout en répondant aux problématiques de distribution géographique des données et des utilisateurs raccordés au travers de moyens de télécommunications militaires souvent contraints en termes de bande passante et de débit », résumé M. Gouttefarde.

En outre, il nécessite le développement d’une « plateforme de confiance » alors que celles qui sont pour le moment disponibles sont d’origine américaine ou chinoise. « Il convient donc d’offrir à court-moyen terme une plateforme de confiance française / européenne, en particulier pour les systèmes à haute sensibilité », souligne donc le député.

Mais, dans son rapport, celui-ci s’interroge. « Le ministère des Armées fait-il montre d’une ambition démesurée avec le projet ARTEMIS? », demande-t-il en effet. Les avis qu’il a recueillis sont divergents, dit-il. Cependant, fait-il remarquer, la « contruction d’une ‘usine de traitement du big data’ semble contradictoire avec le fait que les technologies liés au traitement des données et à l’IA évoluent très régulièrement ». Or, continue le député, « avec ce ce programme, le ministère des Armées est en train de concevoir un super système d’analyse des données qui ne fonctionnera que dans 3 ans au plus tôt, c’est-à-dire à un moment où quasiment toutes les technologies impliquées auront évolué ».

Aussi, le rapporteur estime que « plutôt que d’élaborer un système unique d’analyse de l’ensemble des données du ministère des Armées, il eut été peut-être plus opportun d’appréhender la problématique par domaines d’activité, en développant un programme pour le MCO, un programme pour les données de santé, etc. ».

En outre, M. Gouttefarde pense que les Armées, directions et services [ADS] risquent « d’attendre encore longtemps avant que cet outil ne fournisse de premiers résultats » d’autant plus que, à ce jour, « personne ne sait précisément comment il sera déployé sur le plan opérationnel et comment il s’intégrera aux systèmes déjà existants ». Ce qui fait que, selon lui, « certaines directions du ministère des Armées ont d’ailleurs anticipé de potentiels retards de mise en œuvre en privilégiant des outils internes immédiatement opérationnels ».

L’une des difficiltés est qu’ARTEMIS devra se connecter aux systèmes d’informations [SI] déjà en place. « L’intégration du projet ARTEMIS aux SI existants est au cœur de la problématique : on doit chercher en permanence à intégrer de nouveaux projets à un écosystème préexistant », admet la Direction générale du numérique et des systèmes d’information et de communication [DGNUM].

S’il ne conteste pas le bien-fondé du projet ARTEMIS, M. Gouttefarde s’interroge cependant sur le « niveau d’ambition de certains projets emblématiques du ministère des Armées en matière de numérique ». Ainsi, continue-t-il, « si le caractère intellectuellement séduisant du projet ne fait aucun doute, [il] souligne le fait qu’il y a souvent un décalage important entre la théorie et la pratique dans ce domaine, en particulier eu égard aux divers et nombreux SI au sein du ministère, et qu’il serait regrettable de poursuivre un projet par simple dogmatisme si celui-ci démontre son caractère inopérant et inadapté ».

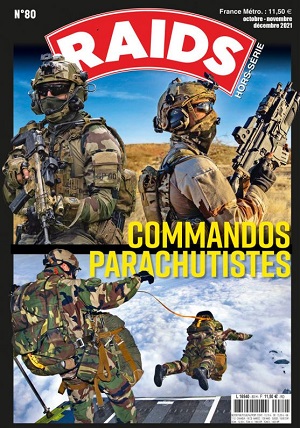

Photo : ATOS