Pour Thales, il n’est pas question de doter des « robots tueurs » d’une intelligence artificielle

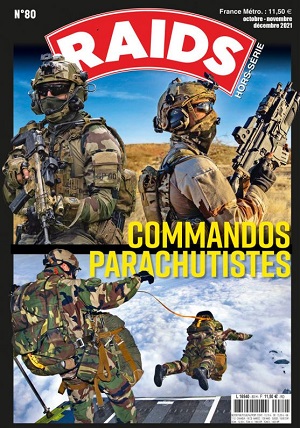

Actuellement, il existe plusieurs types de robots terrestres à usage militaire, classés selon trois catégories : les mini-robots modulaires pour les actions de contact, les véhicules de combat robotisés et les robots lourds de type polyvalent (RTP). Et les projets dans ce domaine se multiplient un peu partout, y compris en France, même si, pour le moment, le ministère des Armées cherche avant tout à développer des machines faites pour soulager les combattants débarqués de certaines tâches pénibles.

Ainsi, par exemple, lors du dernier salon Eurosatory, dédié à l’armement terrestre, MBDA et l’estonien Milrem Robotics ont présenté THeMIS, un robot « antichar » doté du Missile Moyenne Portée. Et Nexter Robotics en a fait de même avec Opto, armé d’un canon de 20 mm. Mais on pourrait citer aussi le Multi Mission Unmanned Ground Vehicle de l’allemand Rheinmetall ou encore le RoBattle d’Israel Aerospace Industries, lequel peut être autonome alors qu’il a été conçu pour des missions de surveillance, de protection et de reconnaissance armée. Certains de ces robots armés ont même été utilisé au combat, comme l’Uran, engagé par les forces russes en Syrie.

Une autre piste de travail vise à faire des chars de combat des engins pilotés à distance. La Russie prépare ainsi une version sans équipage de son Armata T-14. La Chine en a fait de même en modifiant un T-59 [version locale du T-54/55 soviétique]. Et les États-Unis vont suivre, dans le cadre de leur programme Next-Generation Combat Vehicle [NGCV].

Tant que l’ouverture du feu relèvera d’une décision humaine, alors cela ne soulèvera pas des considérations morales et éthiques. Du moins pas autant que si ces machines sont pourvues d’une intelligence artificielle afin de les rendre autonomes. Or, pour certains, cela serait inéluctable.

Dans un rapport publié en 2014, le Center for a New American Security [CNAS] estimait que les véhicules aériens [drones] et terrestres allaient être « bientôt remplacés par des systèmes plus autonomes dans tous les domaines (air, mer, marins, terrestres et spatiales) et dans toute la gamme des opérations militaires » par « nécessité opérationnelle » et aussi en raison de l’augmentation, « à un rythme insoutenable », des coûts de développement des plates-formes traditionnelles de combat avec équipage.

Certes, on peut toujours se référer aux lois de la robotique énoncées par l’écrivain Isaac Asimov, lesquelles stipulent qu’un « robot, doté d’une intelligence artificielle ne peut porter atteinte à un être humain » et qu’il « doit obéir aux ordres, sauf si ces derniers entrent en conflit avec la première régle. » Mais nul ne peut dire qu’elles seront toujours observées.

Aussi, des chercheurs [le regretté Stephen Hawking] et des entrepreneurs du secteur des hautes technologies [Elon Musk, Bill Gates, Steve Wozniak, etc] ne cessent de mettre en garde contre la tentation des robots tueurs autonomes. De même que les Nations unies, dont le Groupe des experts gouvernementaux sur les systèmes d’armes mortelles autonomes [GCE-LAWS] se heurte au refus de certains pays de « toute interdiction, moratoire ou régulation sur les armes autonomes ». La Russie, les États-Unis et la Chine étant parmi ceux se montrant les plus réticents à une éventuelle révision de la convention de 1980 sur l’interdiction ou la limitation de l’emploi de certaines armes classiques.

Aussi, la position affichée par Patrice Caine, le Pdg de Thales est inédite pour un acteur majeur de l’industrie de défense.

Le 24 janvier, à l’occasion de la seconde édition des Thales Media Days, organisée à Montréal et dédiée à l’intelligence artificielle, M. Caine a dit vouloir l’interdiction des robots tueurs autonomes. « Il faut que les pays mettent en place une législation au niveau international pour que le terrain de jeu soit clair pour tous » en ce qui concerne l’application de l’IA au domaine de l’armement, a-t-il expliqué auprès de l’AFP.

« C’est vrai qu’il y a des discussions sur ce sujet là aux Nations unies » et que « globalement il y a une volonté, mais ça prend du temps », a ajouté M. Caine.

Depuis 2014, Thales a investi 7 milliards d’euros dans les domaines de la connectivité, du big data, de la cybersécurité et de l’intelligence artificielle, ces technologies étant de plus en plus utilisées dans les secteurs de l’aéronautique, du spatial, des transports terrestres, de la défense et de la sécurité. Et le groupe consacre 20% de son chiffre d’affaires à la recherche et au développement. Ce qui lui donne une force de frappe appréciable…

Lors de cette conférence, le fondateur et directeur de l’Institut des algorithmes d’apprentissage de Montréal [MILA], Yoshua Bengio, est allé dans le sens du Pdg de Thales. « Il y a deux aspects à considérer à propos des armes létales autonomes, qu’on surnomme les ‘robots tueurs’ et qui n’ont rien d’un film mais constituent au contraire un enjeu actuel pour les armées : il y a l’aspect moral et l’aspect sécuritaire », a-t-il souligné.

« D’un côté, les machines ne comprennent pas et ne comprendront pas dans un futur proche, le contexte moral et de l’autre, si ces armes deviennent faciles à acheter car beaucoup d’entreprises en fabriquent, pensez aux drones construits avec des armes et de la détection faciale : vous aurez alors des assassinats ciblés visant des groupes de population en particulier », a expliqué le Dr Bengio.

Quoi qu’il en soit, il n’est pas question pour Thales de « donner de l’autonomie à un système d’armes pour que de lui-même il puisse décider de tuer ou pas », assuré M. Caine. Thales « n’appliquera pas l’IA dans tout ce qui est létal (même) si les clients le demandent », a-t-il insisté.

Un autre sujet relatif à l’intelligence artificielle est la reconnaissance faciale. Et il s’agit-là d’une technologie qui figure dans le portefeuille d’activités de Thales [et ce sera d’autant plus le cas après le rachat de Gemalto, ndlr]. Or, des pays, comme la Chine, envisage d’y recourir pour surveiller en permanence leur population. Il se dit même que c’est déjà le cas.

« On utilise ces technologies pour des applications de sécurité: pour un port, un aéroport, et autres infrastructures critiques », mais « jamais » Thales ne les a utilisées « à l’échelle d’un pays », a précisé M. Caine.

« Je pense que dans les pays qui le font – si tant est que c’est vrai car les pays qui le font ne communiquent pas là-dessus – l’ingénierie système est faite par les pays eux-mêmes », a-t-il continué le Pdg de Thales, estimant qu’un « système qui noterait les gens sur leurs comportements plus ou moins civiques » pose des « problèmes éthiques et moraux » et représente un danger.